微服务架构下的服务监控与追踪 数据处理与存储的技术支撑

随着微服务架构的广泛应用,系统的复杂度呈指数级增长。一个业务请求往往需要横跨多个独立部署的服务实例,这使得传统的单体应用监控方式难以为继。服务监控与追踪,作为微服务可观测性的核心支柱,对于保障系统稳定性、快速定位故障、优化性能至关重要。而这一切的背后,都离不开强大、高效的数据处理与存储能力的支撑。

一、监控与追踪数据:海量、多维、实时

微服务环境产生的监控与追踪数据具有鲜明的特征:

- 海量性:每个服务实例都会持续产生日志、指标(Metrics)和追踪(Traces)数据。在大型分布式系统中,每秒产生的数据点可达百万甚至千万级别。

- 多维性:数据包含丰富的维度信息,如服务名、实例ID、主机IP、请求路径、HTTP状态码、耗时、错误类型等,便于从不同角度进行聚合与分析。

- 实时性:为了能及时告警和快速响应故障,数据从产生、收集到可查询分析的延迟需要尽可能低,通常要求在秒级甚至亚秒级。

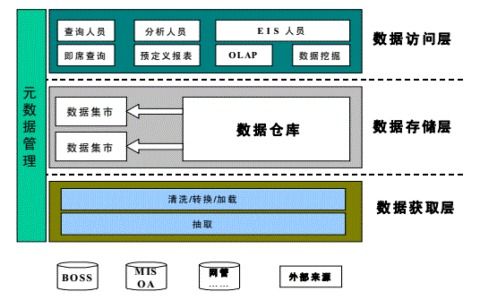

二、核心数据处理流程

数据处理流程构成了监控与追踪的“血液循环系统”,通常包含以下环节:

- 数据采集(Collection):

- 代理模式:在每个服务节点部署轻量级代理(如Prometheus Node Exporter, OpenTelemetry Collector),负责收集主机、容器及应用的指标和追踪数据。

- 埋点/SDK模式:应用通过集成SDK(如OpenTelemetry, Micrometer)在代码层面主动上报数据。

- 日志抓取:使用Filebeat、Fluentd等工具从日志文件中实时采集和解析结构化日志。

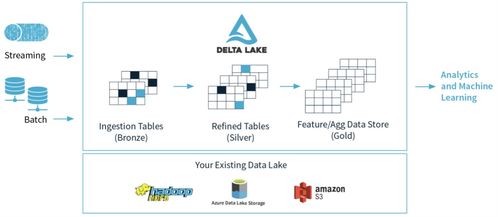

- 数据传输与聚合(Transport & Aggregation):

- 采集到的数据通常先发送到消息队列(如Kafka)或流处理平台进行缓冲,以削峰填谷,解耦生产与消费速率。

- 聚合层(如StatsD, Telegraf)可以对原始指标进行初步的聚合计算(如求和、求平均),减少后端存储压力。

- 数据加工与丰富(Processing & Enrichment):

- 利用流处理框架(如Apache Flink, Apache Spark Streaming)对数据进行实时清洗、过滤、转换和丰富。例如,为追踪数据补充统一的业务标签,或将错误日志与对应的追踪ID进行关联。

三、存储方案的选择与演进

数据的存储是决定监控系统查询效率和分析能力的关键。针对不同类型的数据,需要采用不同的存储策略:

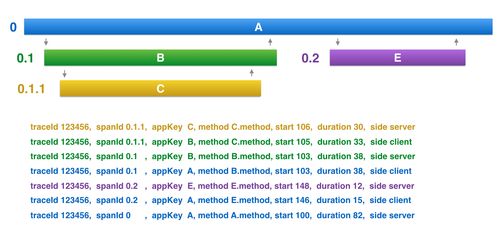

- 指标(Metrics)数据存储:

- 特点:数值型、时间序列数据,通常按固定频率采样。

- 主流方案:时序数据库(TSDB) 是首选,它们为时间序列数据做了高度优化。

- Prometheus:内置TSDB,适用于周期性拉取模型的监控,支持强大的PromQL查询语言,但分布式和长期存储需要与Thanos或VictoriaMetrics等方案结合。

- InfluxDB:高性能的分布式TSDB,支持连续的查询和丰富的聚合函数。

- TimescaleDB:基于PostgreSQL的时序数据库,兼具关系型数据库的易用性和时序数据库的高性能。

- 存储考量:高压缩率、快速的时间范围查询和降采样(Downsampling)能力是核心需求。

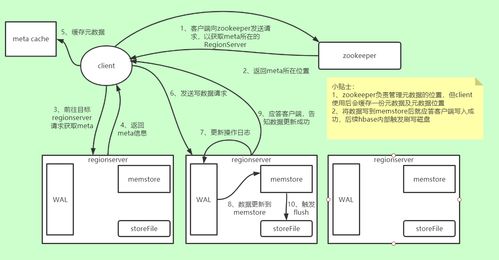

- 追踪(Traces)数据存储:

- 特点:单个追踪(一个请求的完整调用链)数据量大、结构复杂(树状或图状),查询模式多样(如按TraceID精确查询、按服务/耗时范围筛选)。

- 主流方案:

- 专用追踪存储:如Jaeger(默认使用Cassandra/Elasticsearch)、Zipkin(支持多种存储后端)。它们针对追踪数据的存储和查询接口进行了深度优化。

- 通用搜索引擎/数据库:Elasticsearch 因其强大的全文检索、聚合分析和近乎实时的查询能力,被广泛用于存储和索引追踪数据,便于进行复杂的关联分析与故障排查。

- 日志(Logs)数据存储:

- 特点:半结构化或非结构化文本数据,数据量巨大,需要灵活的检索能力。

- 主流方案:Elasticsearch + Logstash + Kibana (ELK Stack) 或其变体(如EFK)是事实上的标准。Elasticsearch提供高效的索引和搜索,Kibana提供可视化分析界面。对象存储(如Amazon S3)也常作为日志的廉价、长期归档仓库。

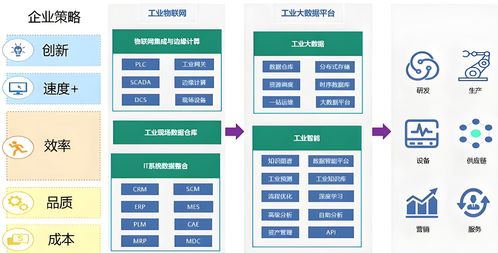

四、统一数据平台与未来趋势

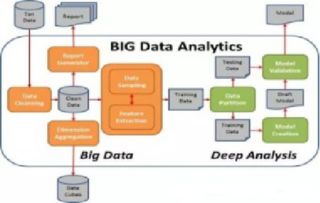

为简化运维并提升效率,现代监控体系正朝着“统一数据平台”的方向演进:

- 统一采集标准:OpenTelemetry 项目旨在提供一套统一的API、SDK和采集器标准,用于生成、收集和处理遥测数据(指标、追踪、日志),终结技术栈绑定的混乱局面。

- 统一存储与查询:出现了一些旨在融合不同类型数据的平台,如Grafana Loki(专注于日志,但理念上与Prometheus的指标、Tempo的追踪紧密集成),允许用户通过类似的标签体系关联查询指标、日志和追踪。

- 云原生与Serverless:存储方案越来越多地以托管服务的形式提供(如Amazon Timestream, Google Cloud Trace),并与Kubernetes等编排平台深度集成,实现自动化的监控数据管理。

- AIOps集成:海量的监控数据是AIOps的燃料。存储系统需要支持与机器学习平台对接,进行异常检测、根因分析、容量预测等智能分析。

###

在微服务架构中,构建一个健壮的服务监控与追踪体系,绝非仅仅是将多个工具简单堆砌。其核心挑战在于如何设计一个能够流畅处理海量、异构、实时数据流的管道,并为这些数据匹配合适、高效的存储与索引方案,最终通过统一的界面将系统状态清晰、及时地呈现出来。数据处理与存储,正是支撑这座“可观测性大厦”的地基与承重结构,其设计与选型的优劣,直接决定了运维团队洞察系统、保障稳定的能力上限。

如若转载,请注明出处:http://www.520hbwl.com/product/59.html

更新时间:2026-02-25 06:34:56